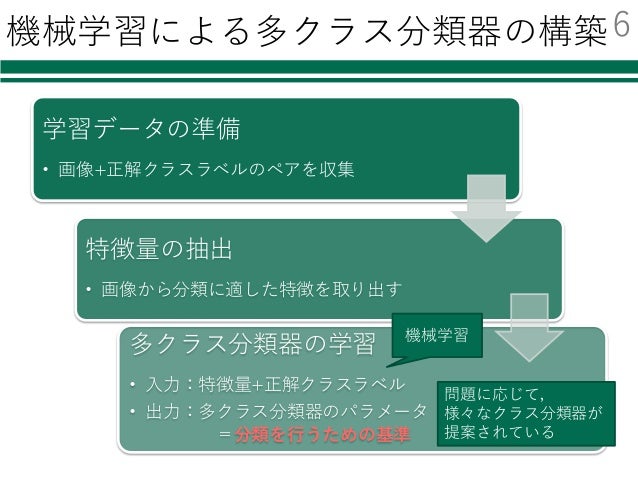

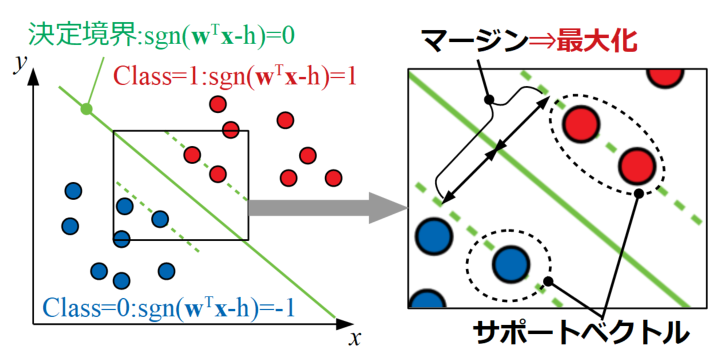

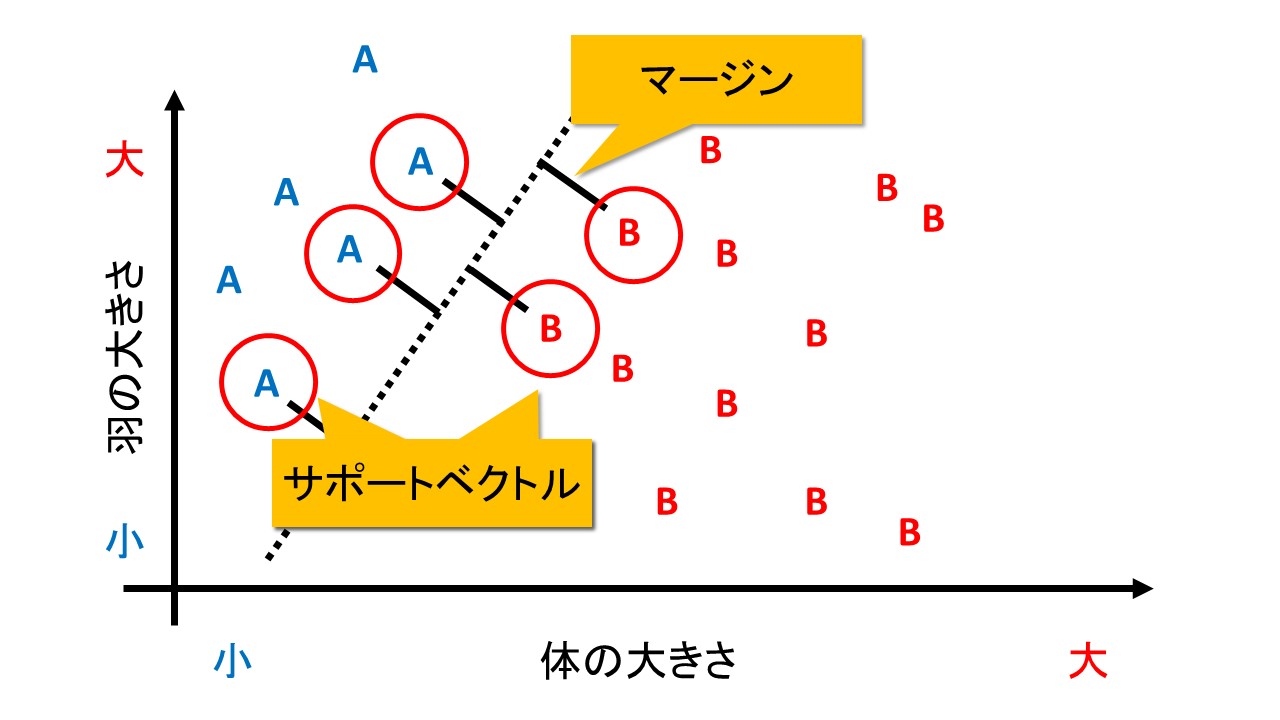

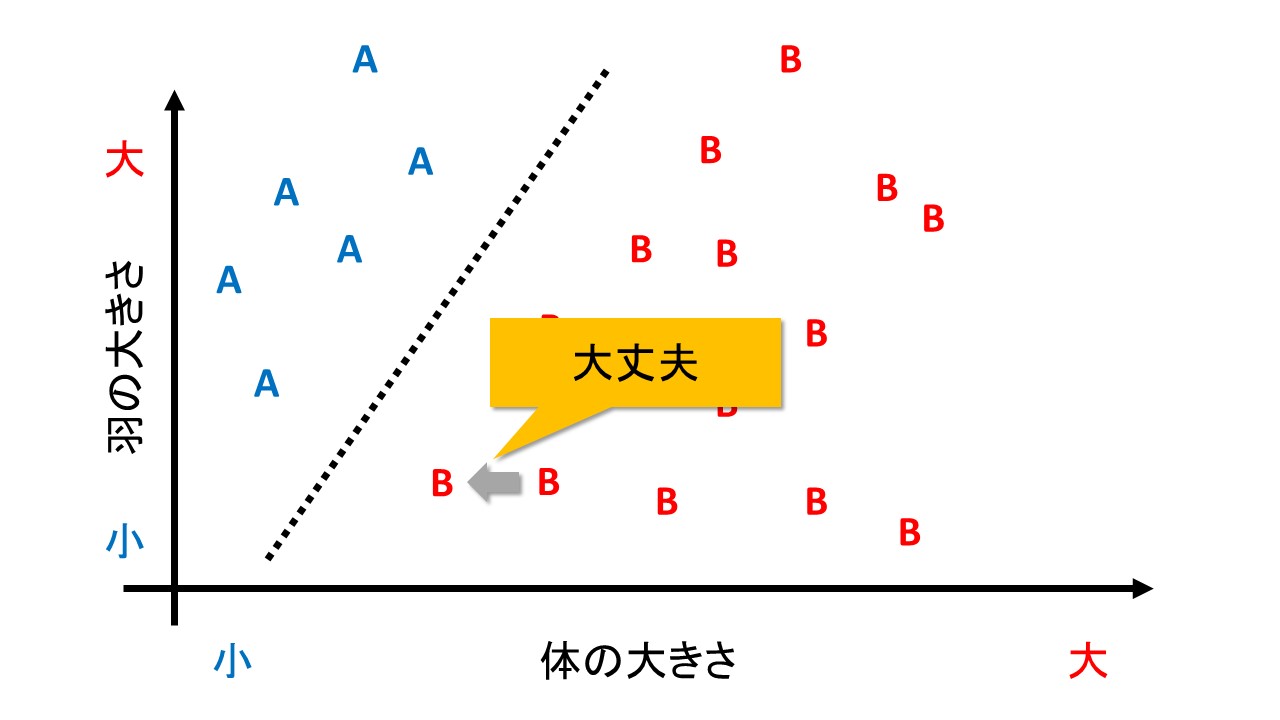

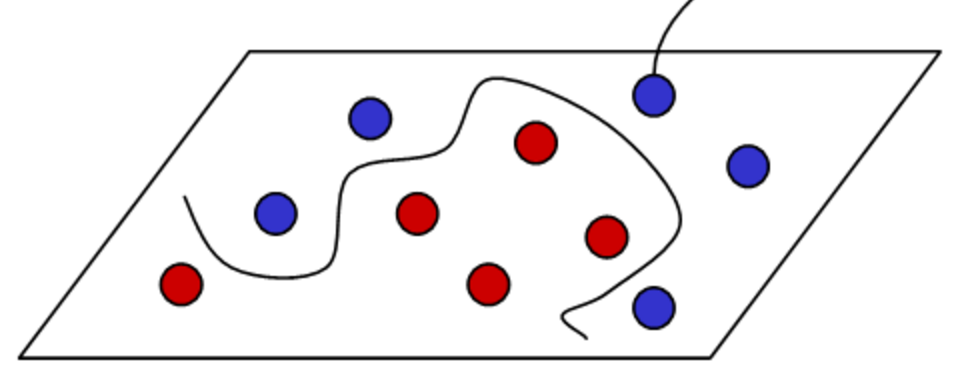

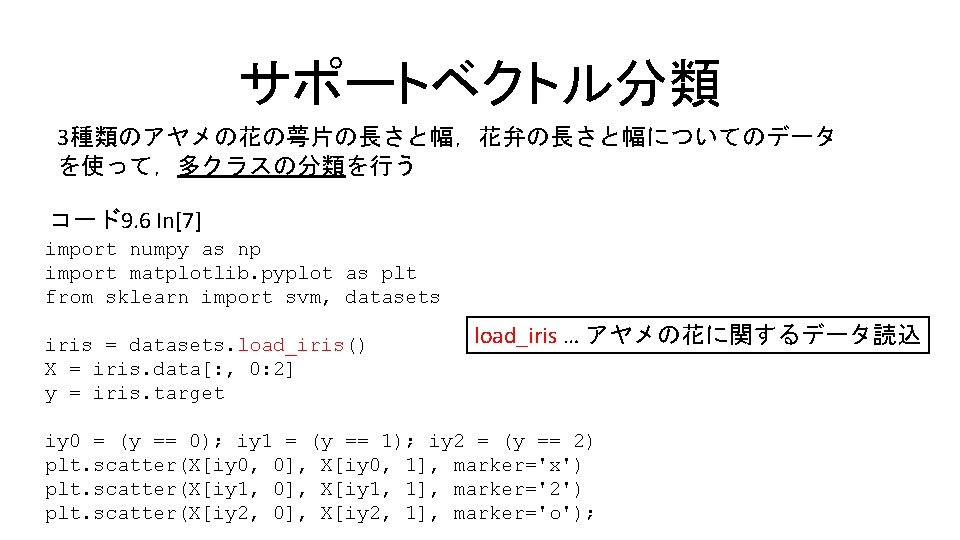

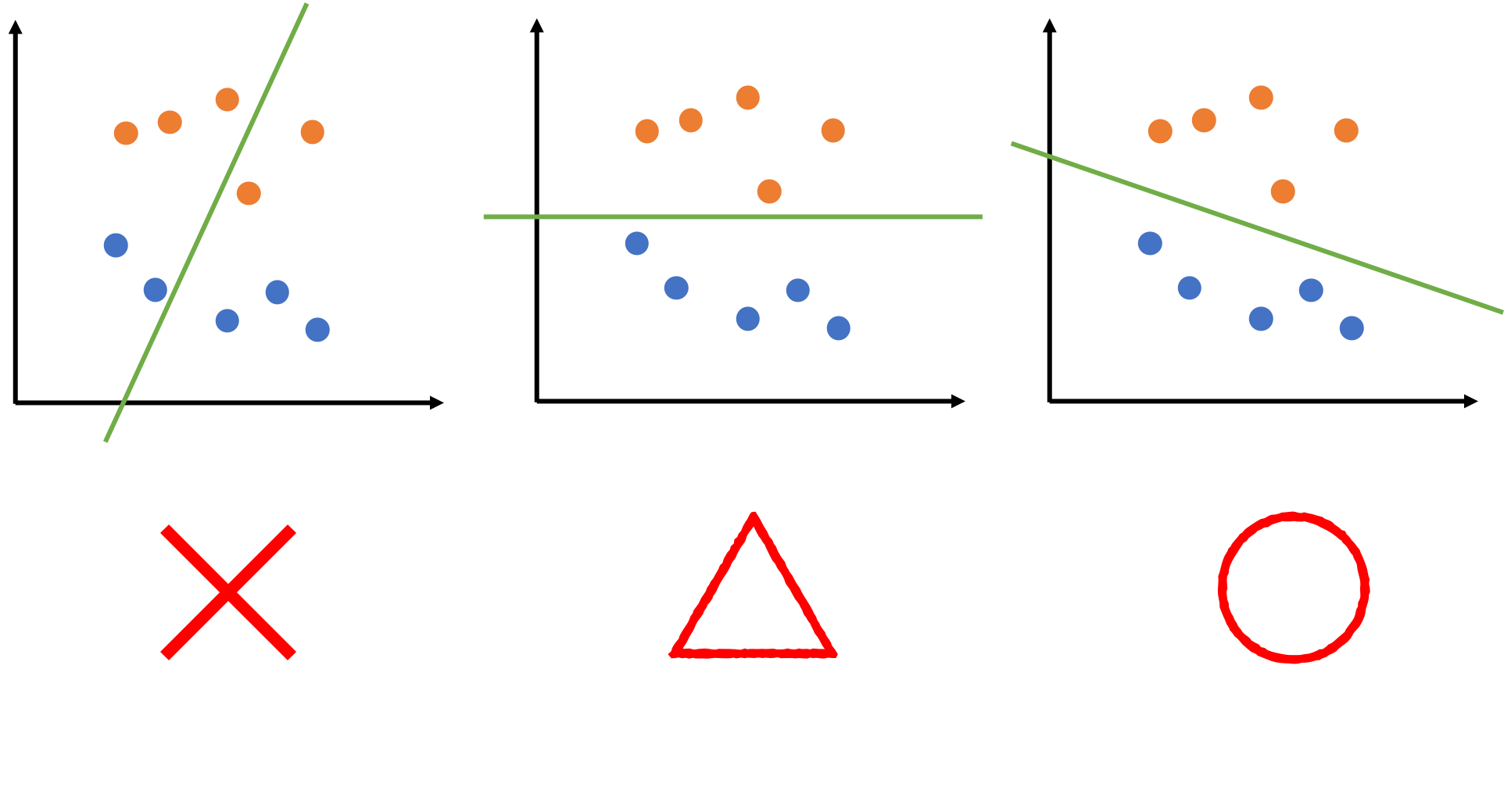

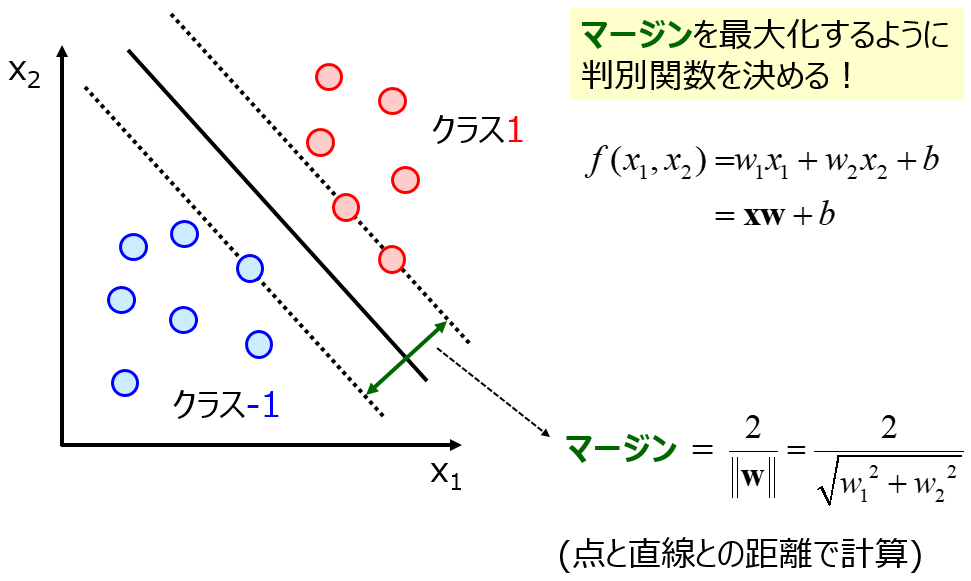

SVM(Support Vector Machine)による多クラス分類 クラス分類を行うときに基本的なアルゴリズムとしてSVM(Support Vector Machine)があります。 SVMはデータのクラスに対してマージンが最大となるように直線を引いてクラスごとに線形分離を行うアルゴリズムです。 Scikitlearnを使ってSVMでクラス分類する方法を解説 こんにちは三谷です。 今回は、AI (人工知能)の一つ、機械学習においてとても有名なアルゴリズムを紹介したいと思います。 機械学習を行う上で、SVM (サポートベクターマシン)はデータの分類をするためにも重要な手法です。 SVM (サポートベクターマシン)の使い方について徹底解説します! Scikitlearnを初めて使うサポートベクターマシンは、線形しきい素子を用いて、2 クラスのパターン識別器を構成する手法 (Support Vector Machine, SVM) と呼ばれるパターン認識手 は2つのクラスを識別する識別器を構成するための学習法であり、文字認識などの多クラスの識別

Svm 多クラス分類 Qiita

Svm 多クラス python

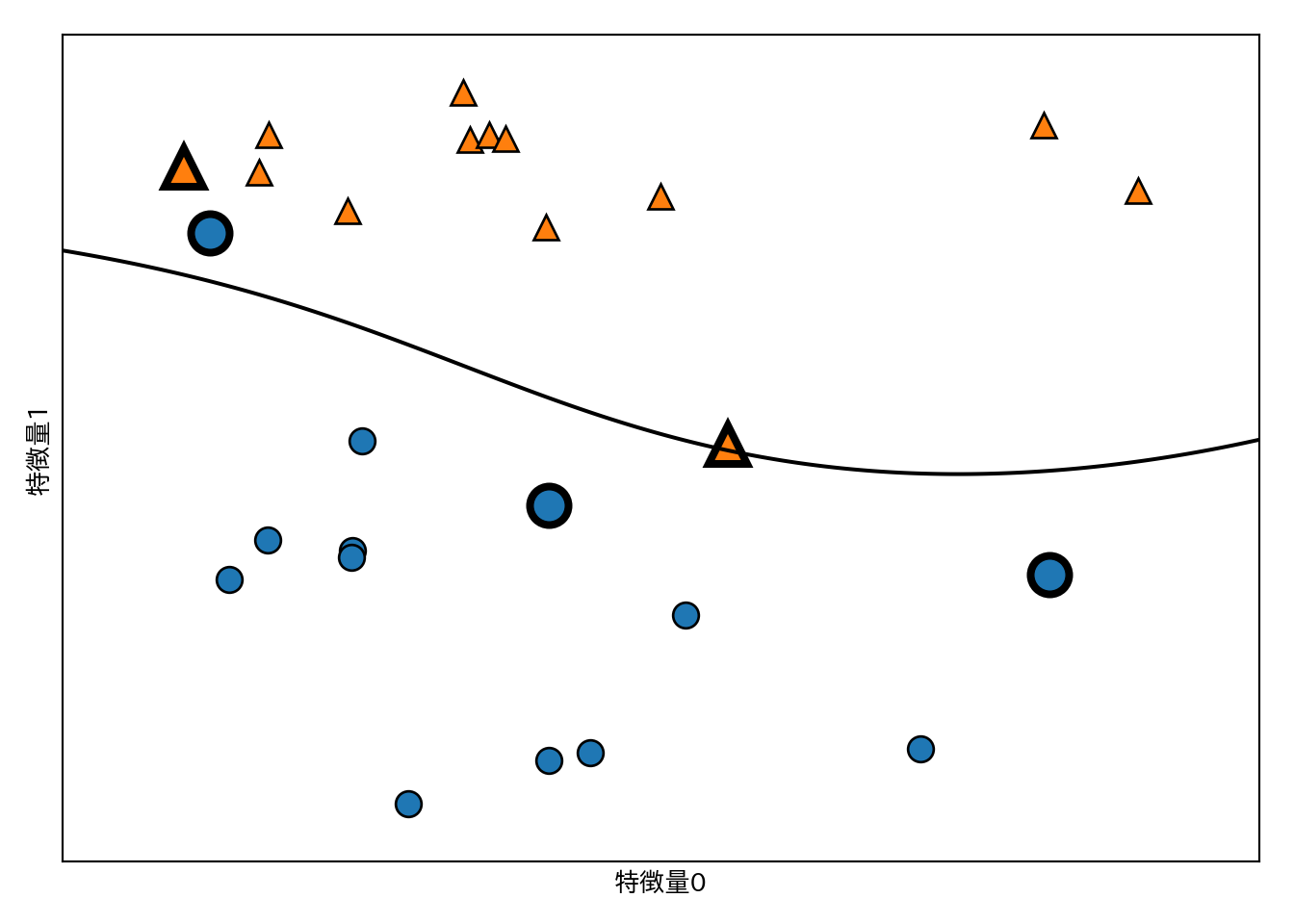

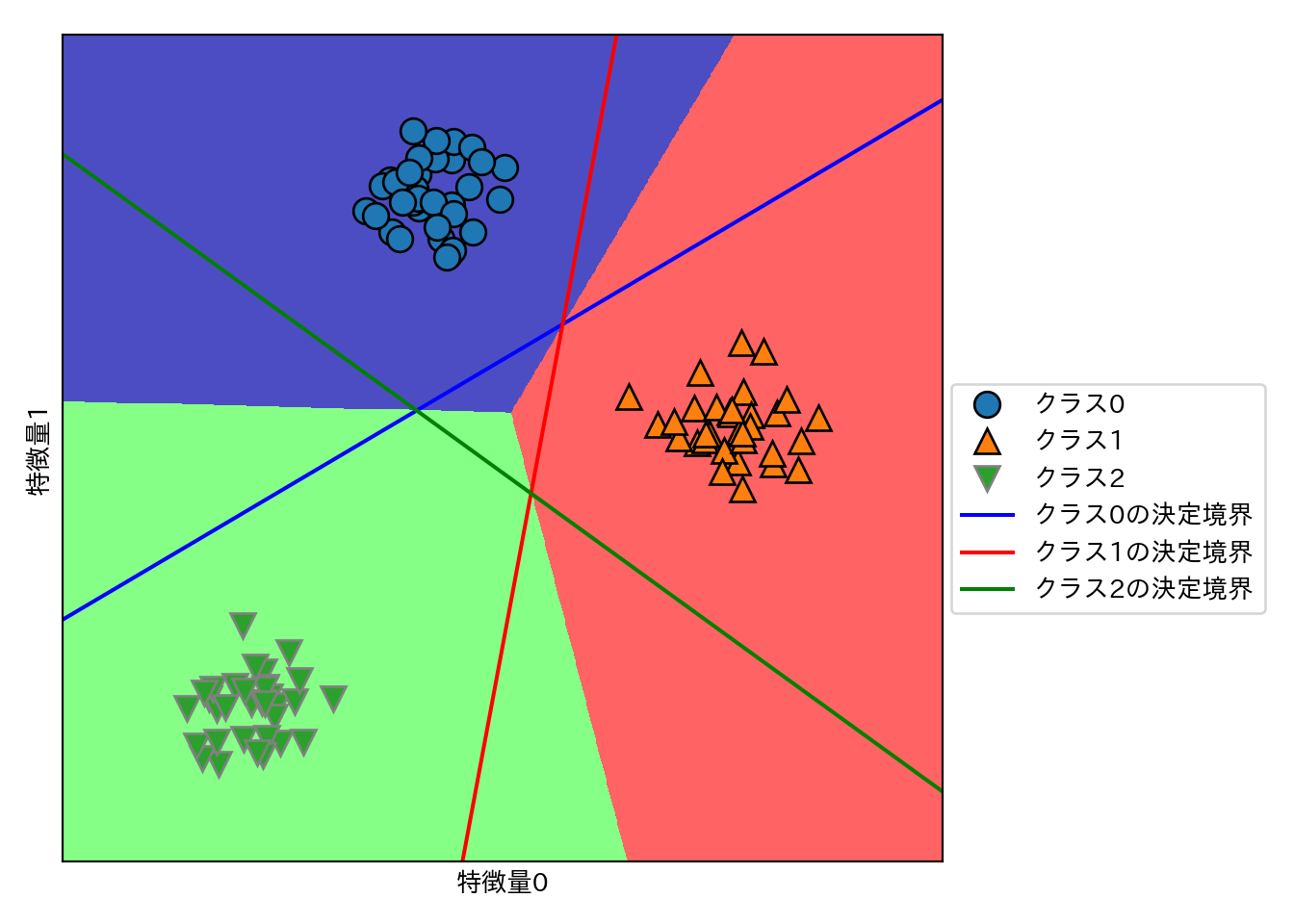

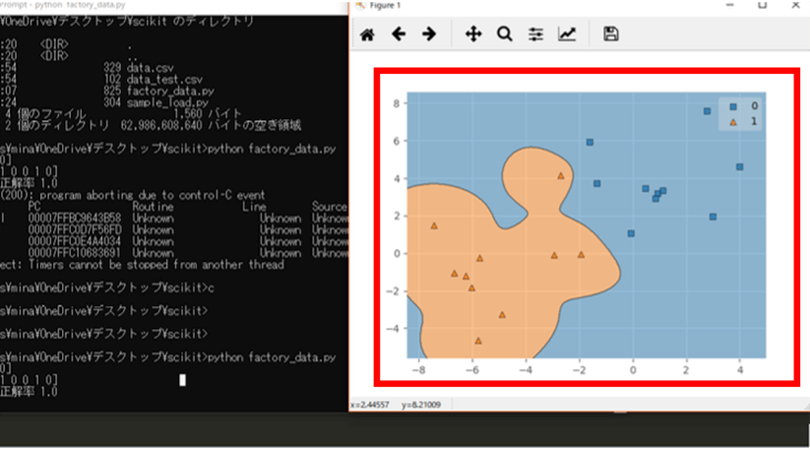

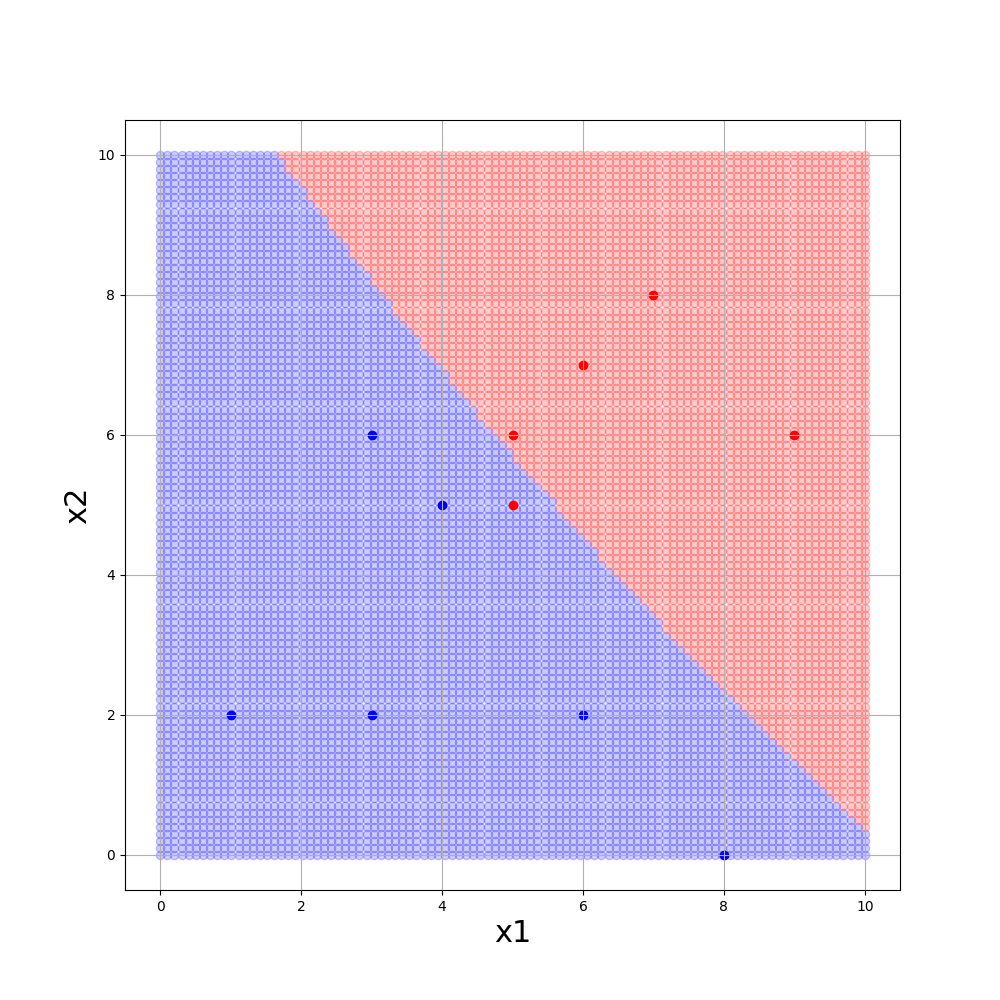

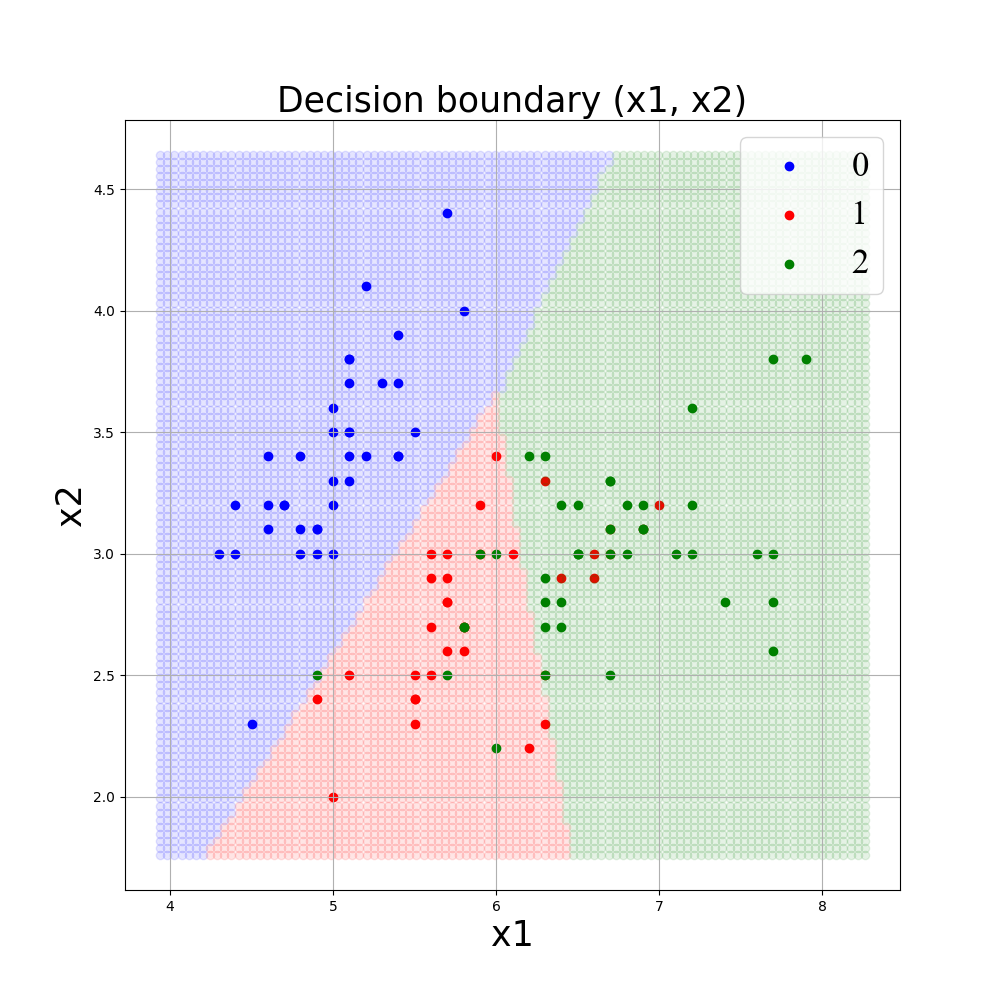

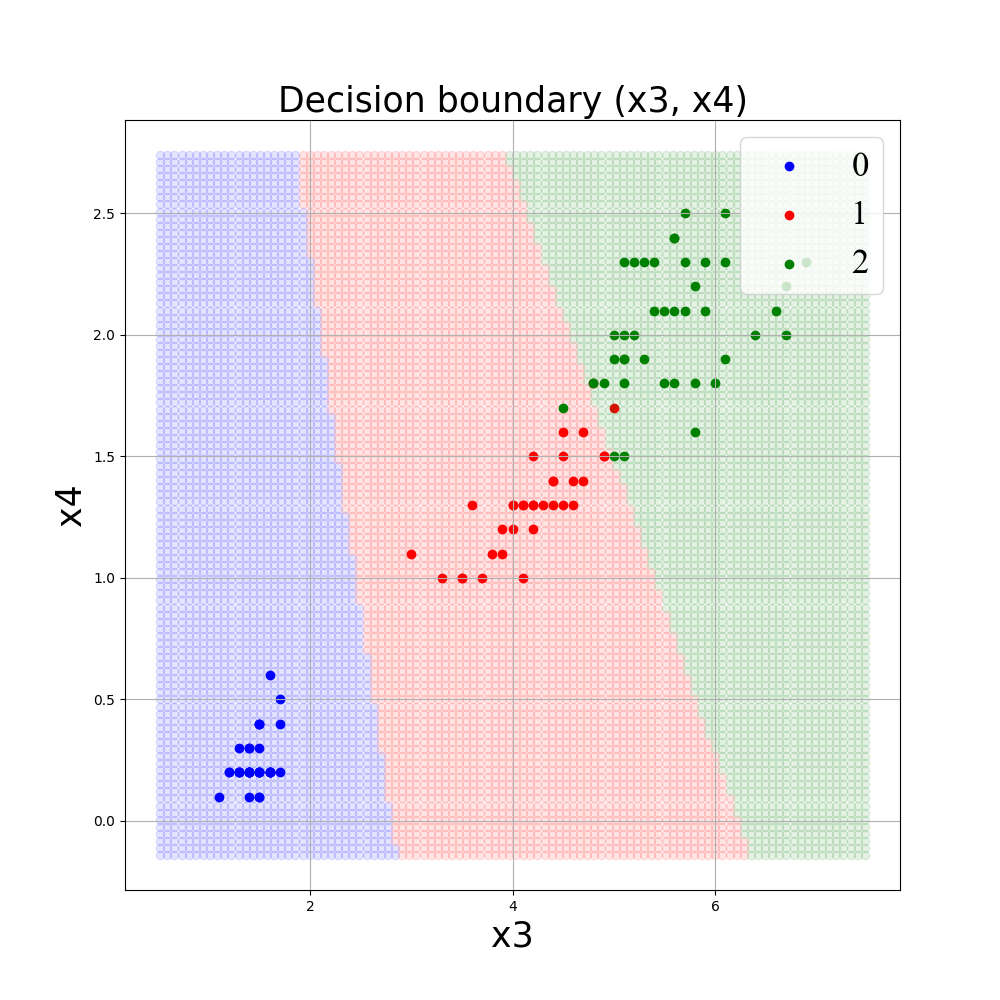

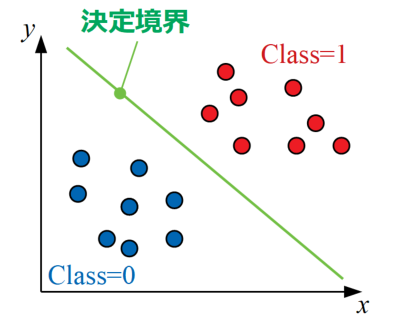

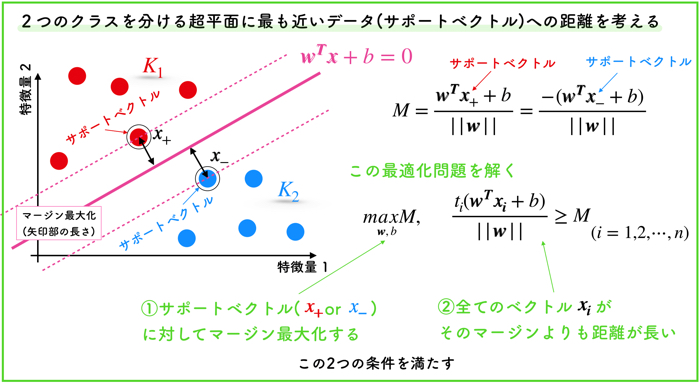

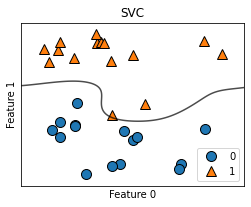

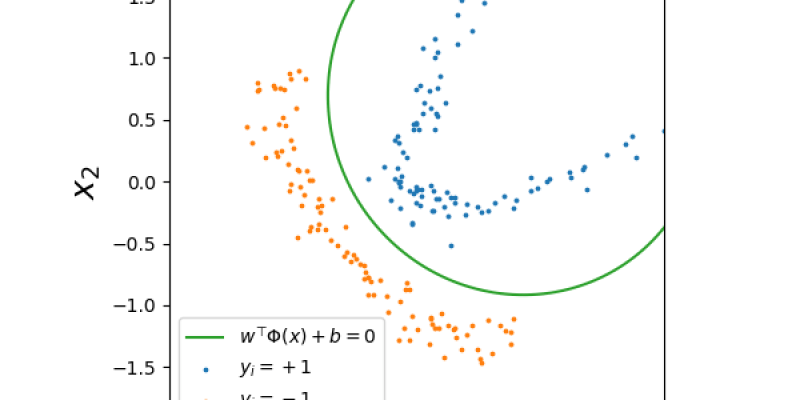

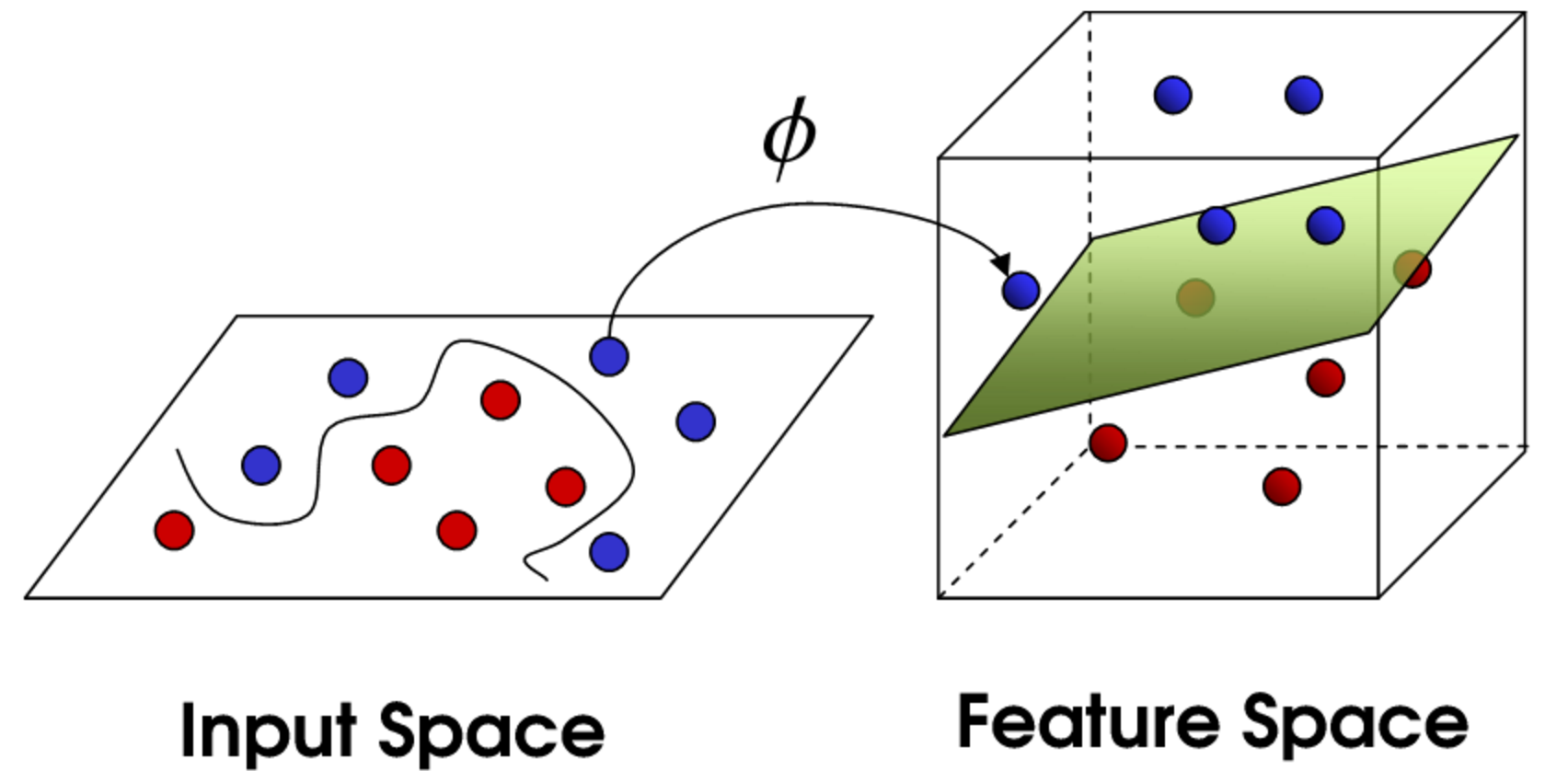

Svm 多クラス python- SVMとは Support Vector Machineの略。 学習データを用いて複数のクラスを分類する線を得て(学習モデル作成)、未知のデータ属する分類を推定する方法。 SVMでの分類の概要 元の次元から1つ低い平面を超平面と呼び、最適な超平面(分離面)を探す。 決定境界 見習いデータサイエンティストの隠れ家 機械学習の分類結果を可視化! 決定境界 機械学習 python 学習した機械学習のモデルが与えたデータに対してどのように分類したかを知りたいことは多いです。 ここら先は違うクラスになると

Pythonによる機械学習入門 Svmからdeep Learningまで

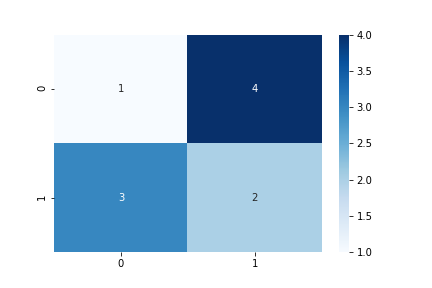

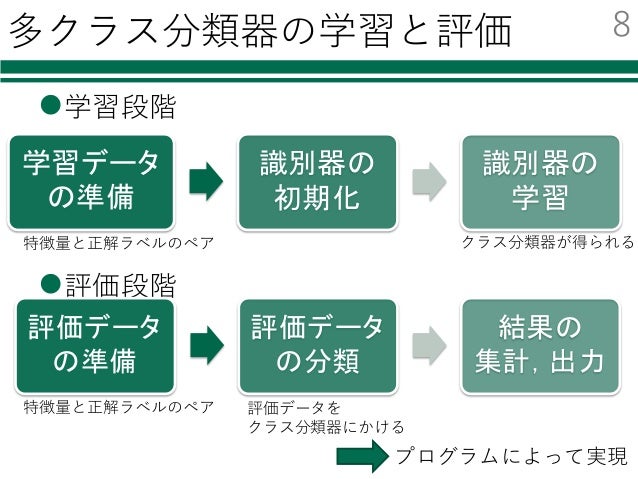

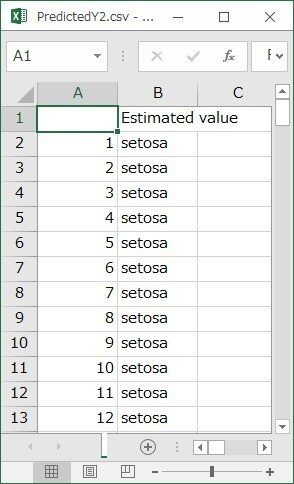

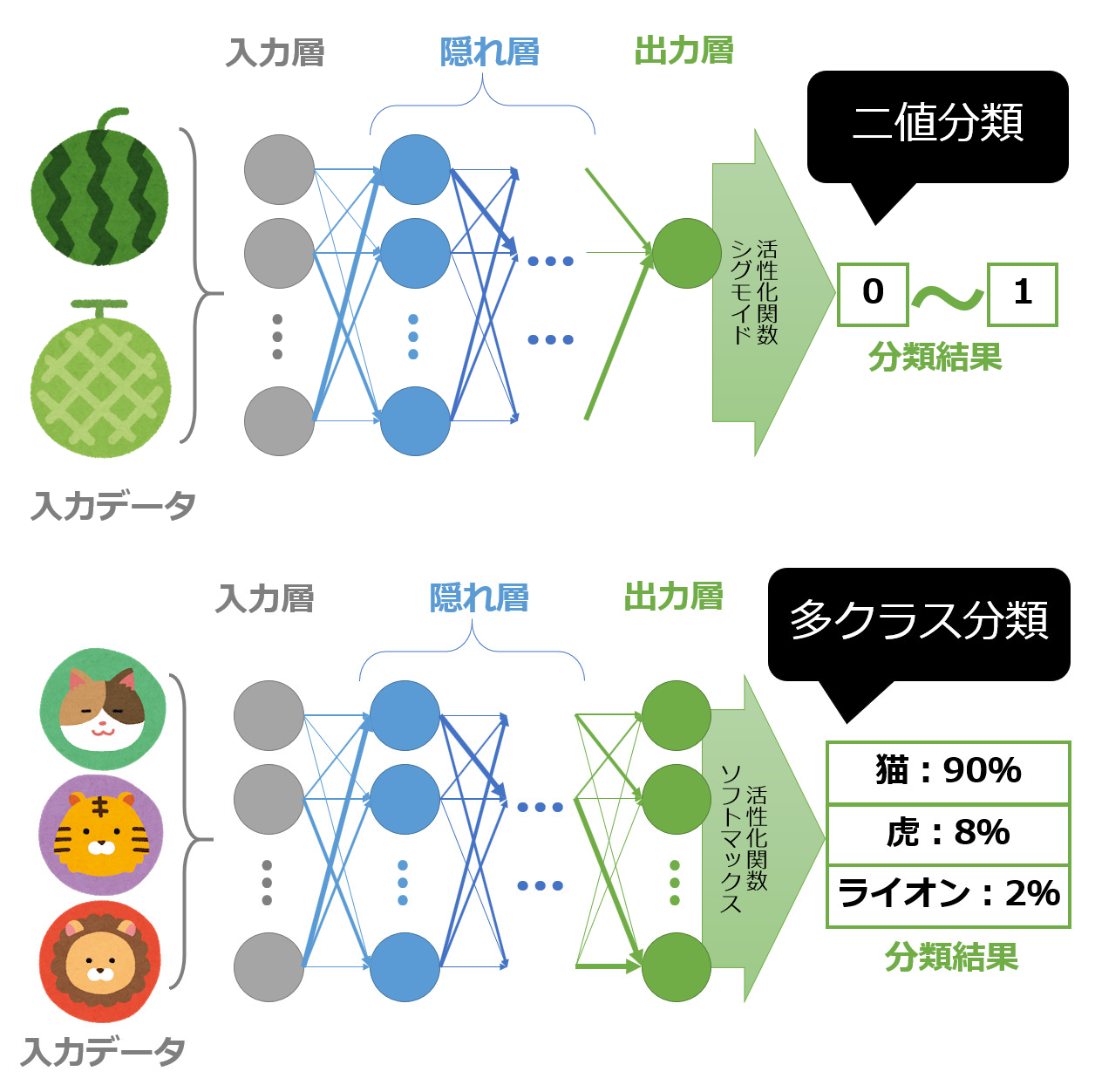

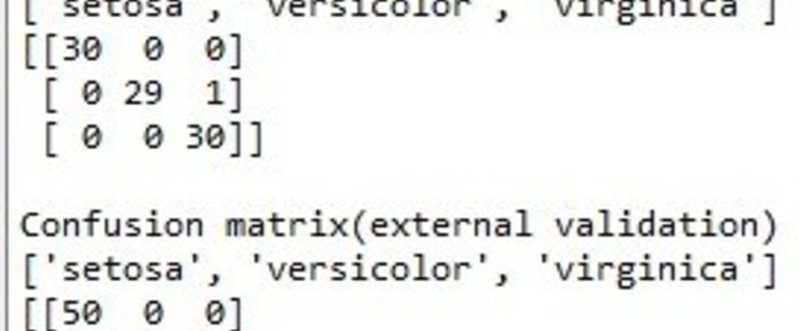

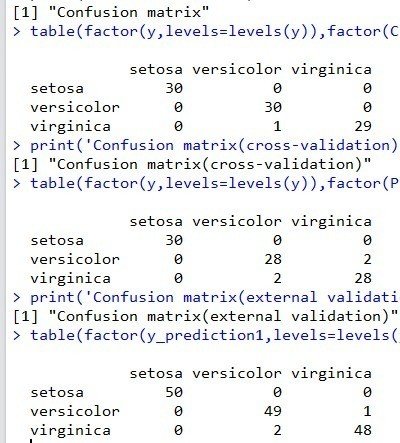

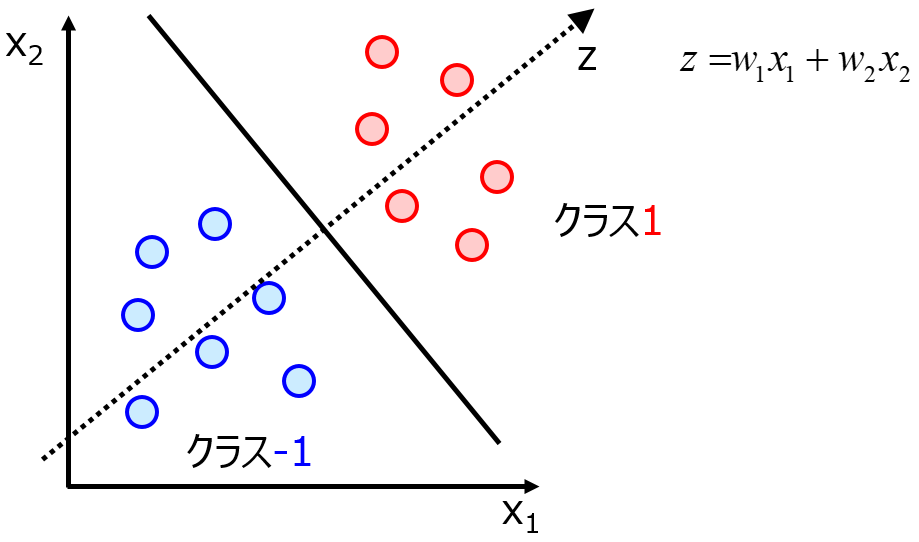

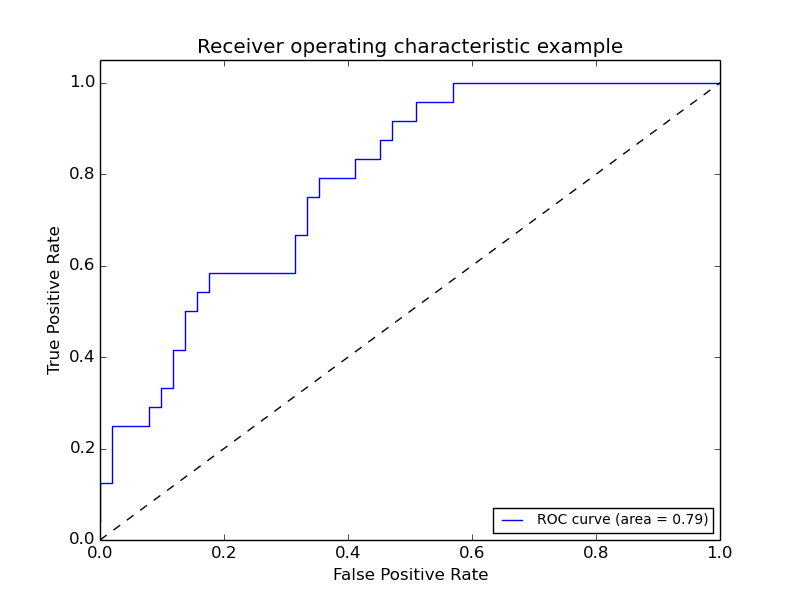

Scikitlearn でクラス分類結果を評価する Last update 本ページでは、Python の機械学習ライブラリの scikitlearn を用いて、クラス分類 (Classification) を行った際の識別結果 (予測結果) の精度を評価する方法を紹介します。サポートベクターマシン(Support Vector Machine、以下SVM)は、教師付き学習においてクラスの数が2つである問題に用いられる線形分類器です。(多クラスSVMなど変種も存在しますが本章では扱いません) まず教師事例を正クラスと負クラスの2クラスに分けます。「未成年と成年」や「課金するユーザと課金しないユーザ」など、目的に応じて2つに分けましょう。 さて、多クラス分類と言っておきながら、前回はデータの準備で終わってしまいました. 今回から実際に分類に入っていきます. 前回の記事はこちら: scikitlearnを用いた多クラス分類(1/3) 他力本願で生き抜く(本気) 最初に言っておきますが、今回も最後までいけません.今回の

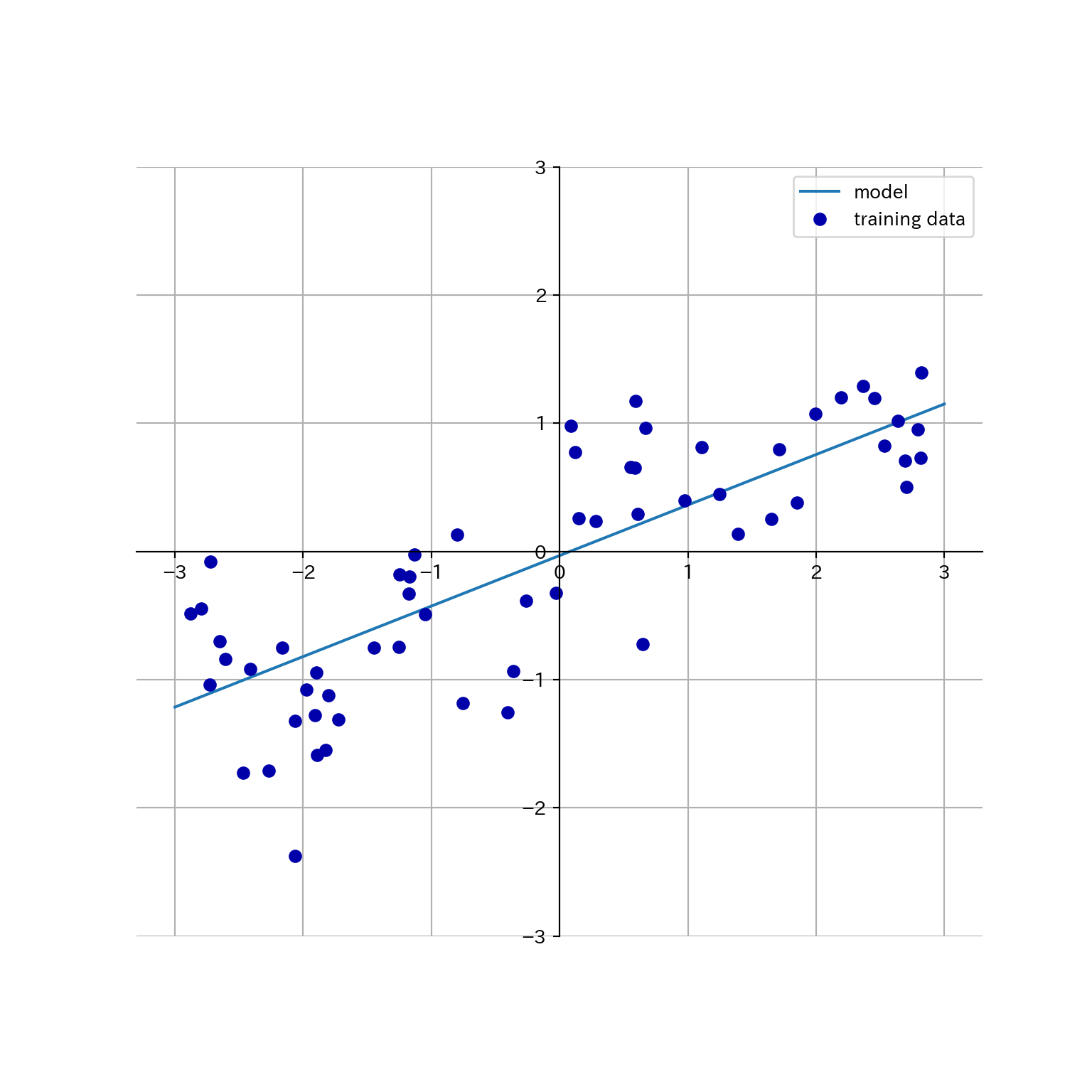

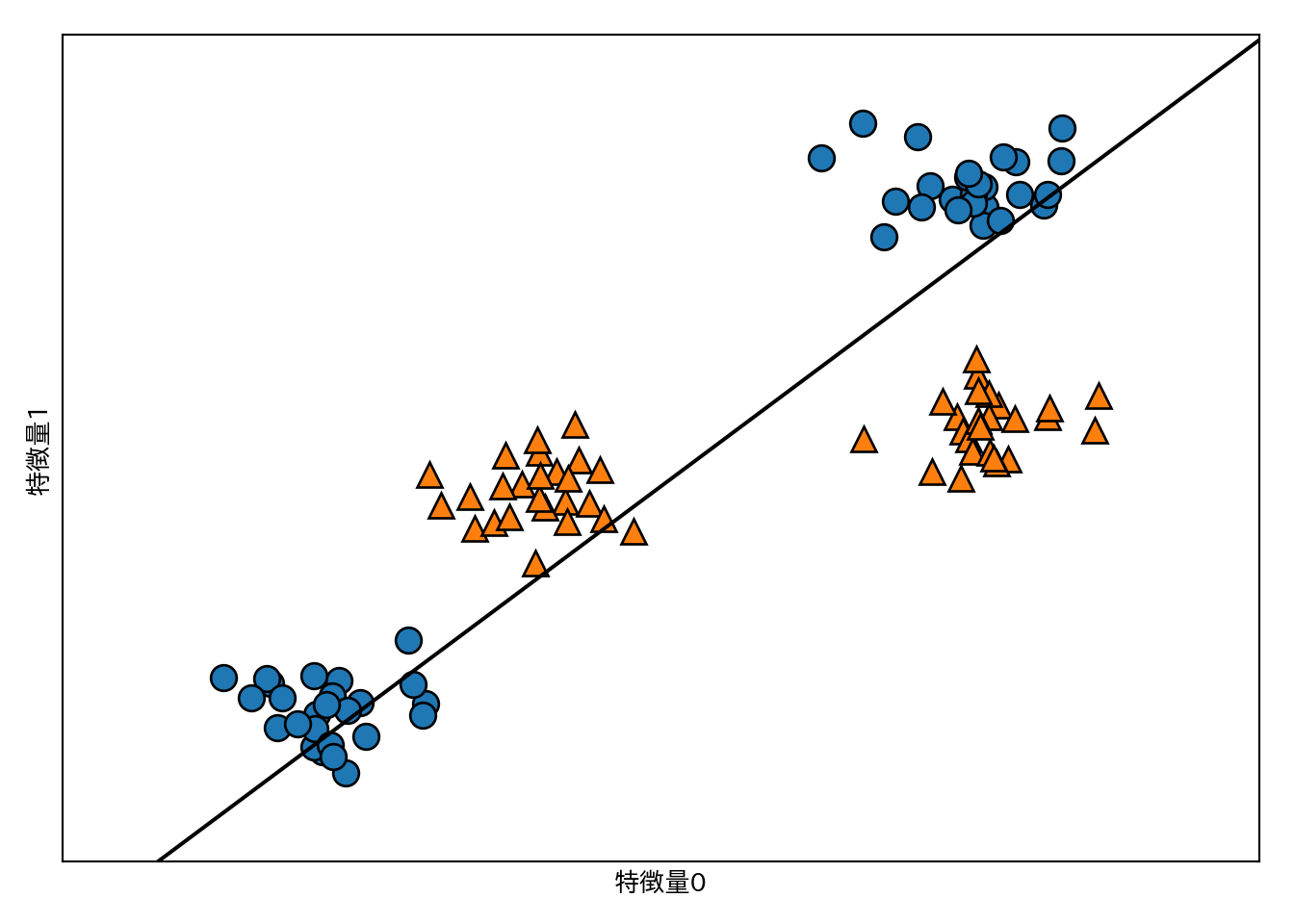

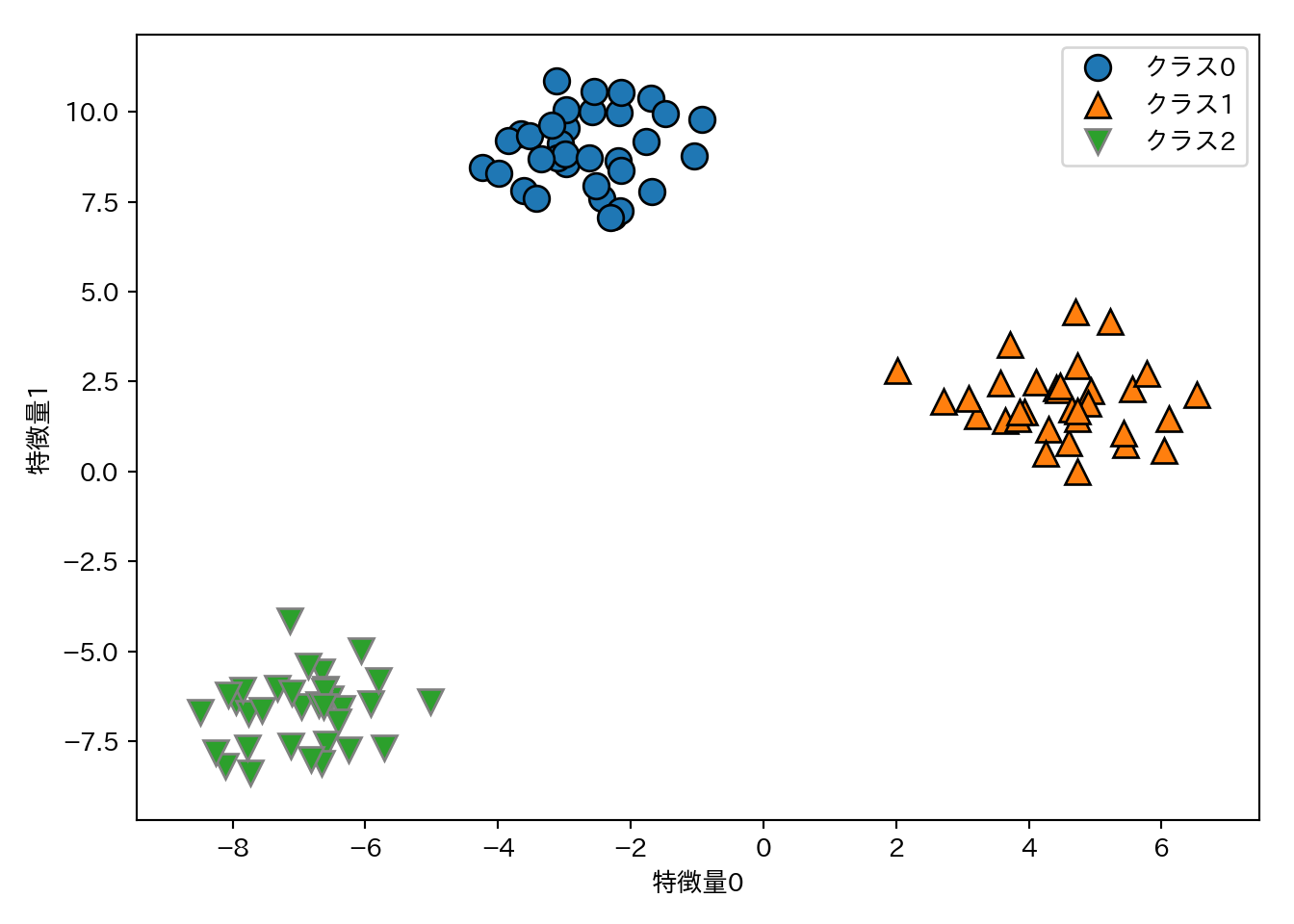

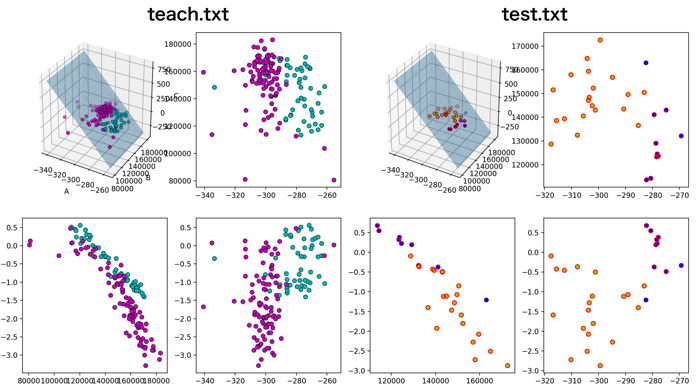

Fit the SVM model according to the given training data Parameters X {arraylike, sparse matrix} of shape (n_samples, n_features) or (n_samples, n_samples) Training vectors, where n_samples is the number of samples and n_features is the number of features For kernel="precomputed", the expected shape of X is (n_samples, n_samples) SVMによる多クラス分類で、すべて同じクラスになる pura 総合スコア 0 Python 3x Python 3はPythonプログラミング言語の最新バージョンであり、08年12月3日にリリースされました。 Windows Windowsは、マイクロソフト社が開発したオペレーティングシステムです 概要 この項はO'REILLYの「Pythonではじめる機械学習」の「2336 線形モデルによる多クラス分類」を自分なりに理解しやすいようにトレースしたもの。 扱いやすい仮想のデータセットを生成し、 LinearSVC モデルでこれらを分類する流れを例示している

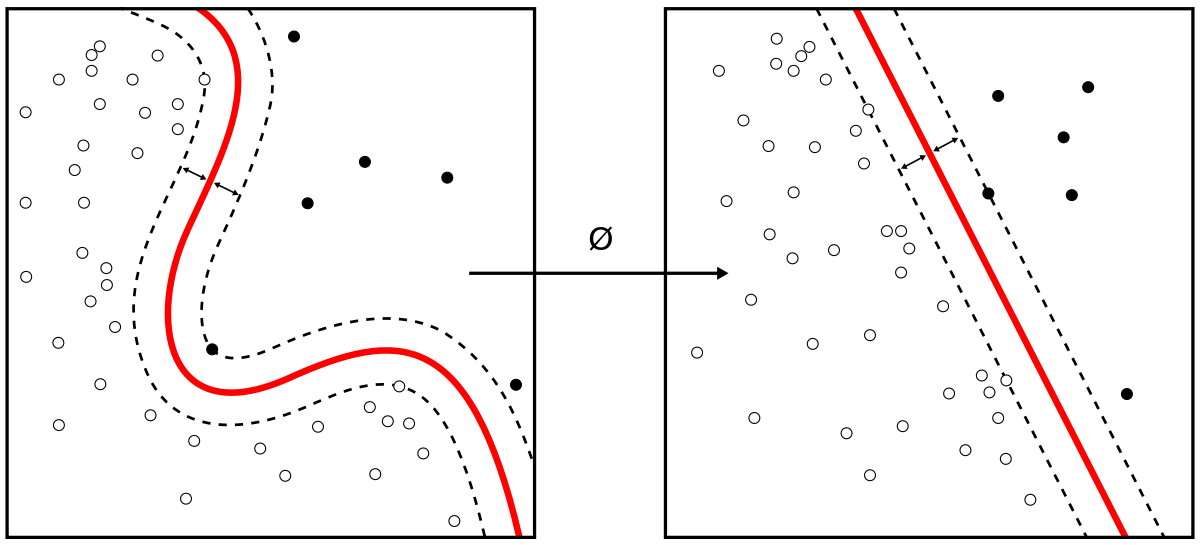

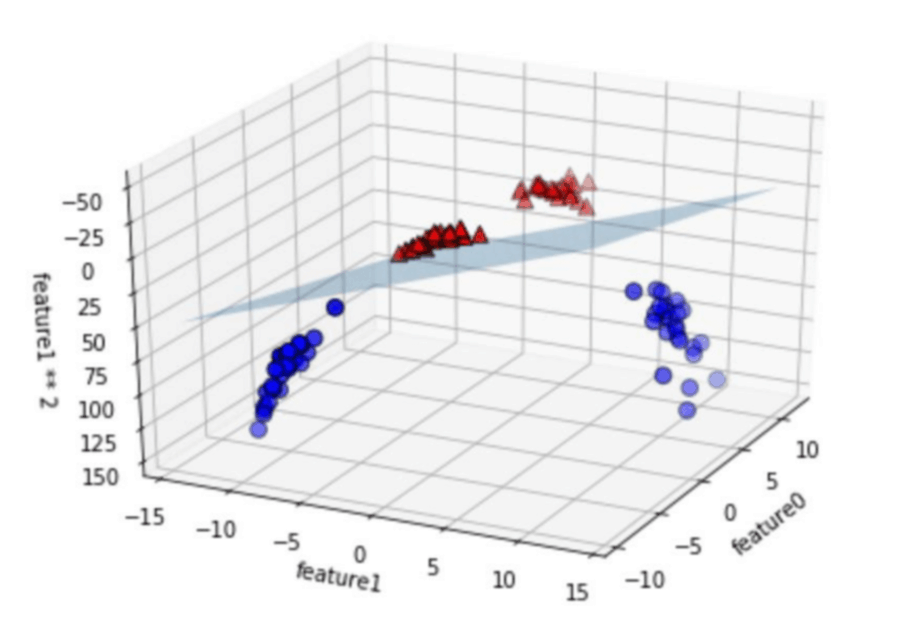

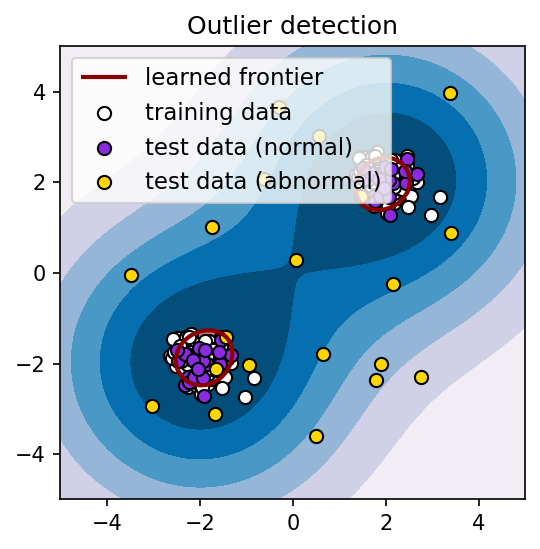

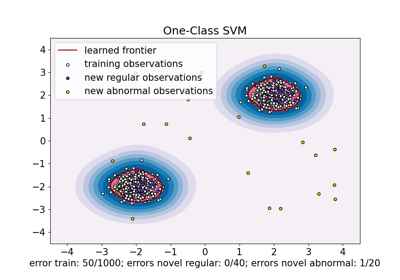

scikitlearnでサポートベクターマシン(SVM)を使う方法 えびかずき こんにちは、えびかずきです。 今回はscikitlearnでサポートベクターマシン(SVM)を使う方法について説明していきます。 こんな人におすすめ: ・scikitlearnの使い方を知りたい ・Pythonで 多クラス分類に適用する SVM に対して、one class SVM は、すべてのサンプルの教師ラベルを 1 とし、原点の教師ラベルを 1 として、分離超平面を決定している。 このように決定された分離超平面を利用することで、未知のサンプルが分離超平面の原点側にSupport Vector Machine algorithms are not scale invariant, so it is highly recommended to scale your data For example, scale each attribute on the input vector X to 0,1 or 1,1, or standardize it to have mean 0 and variance 1 Note that the same scaling must be applied to the test vector to obtain meaningful results

Pythonによるsvm サポートベクターマシン の実行 データサイエンス情報局

Python機械学習初心者用 サポートベクターマシンの概要と実装 Watlab Python 信号処理 Ai

はじめに この章のサンプルプログラムは、Jupyter NotebookのScikitlearnのバージョンが'00'及び、 Google Colab上でScikitlearnのバージョンが'02'にて動作確認ができています。 それ以前のバージョンでは動作しない可能性がありますのでご注意ください。 SVM(Support Vector Machine) SVM(Support Vector svmの説明関数を3次元の状態のまま分類を行いたいと思っています。 Python374で現在SVMを実装しようとしています。 目的関数(data_ofj)はnpndimで"1" 説明関数(data_sets)はnpndimで"3" という状況でfit関数にかけてみていますが、以下のようなエラーに• SVMの多クラス識別問題への適用 – オリジナルのSVMは2値識別のみに適用可能 – Some approaches for extension to multiclass classification • 多クラス識別におけるマージン最大化基準によるSVMの拡張 – Crammer and Singer (01) など – LN

機械学習 サポートベクトルマシン 後編 カーネル法 多クラス分類 回帰問題 Youtube

Pythonで始める機械学習の学習

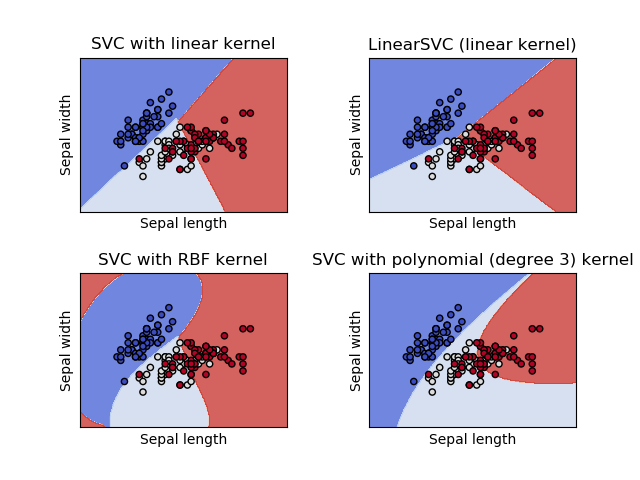

モデル生成 今回は、 SVC における4つのkernelを用いて、それぞれの精度を出して比較してみます。 from sklearnsvm import SVC model_linear = SVC (kernel = 'linear' ) model_poly = SVC (kernel = 'poly' ) model_rbf = SVC (kernel = 'rbf') #kernelを指定しない時のデフォルトです model_sigmoid = SVC (kernel = 'sigmoid' ) クラス分類問題において、データ数がそれほど多くない場合にまず使用するLinear SVC(SVM Classification)について、実装・解説します。 本シリーズでは、Pythonを使用して機械学習を実装する方法を解説します。 また各アル Linear SVC(クラス分類 )(SVM Classification)Pythonとscikitlearnで機械学習:第3回 脳機能計測で博士号を取得した著者 3クラス以上の多クラス分類でも同様に混同行列を生成できる。 y_true_multi = 0 , 0 , 0 , 1 , 1 , 1 , 2 , 2 , 2 y_pred_multi = 0 , 1 , 1 , 1 , 1 , 2 , 2 , 2 , 2 print ( confusion_matrix ( y_true_multi , y_pred_multi )) # 1 2 0 # 0 2 1 # 0 0 3

パッケージユーザーのための機械学習 教師あり学習同士で分離超平面 決定境界を比較してみる 渋谷駅前で働くデータサイエンティストのブログ

Svm サポート ベクタ マシン とpythonで空の写真から天気を判定させてみる Karaage からあげ

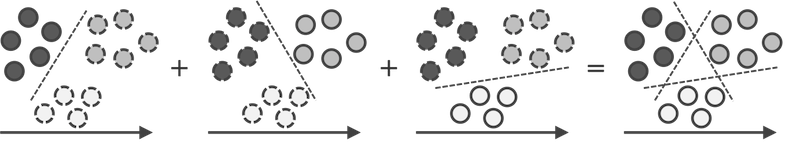

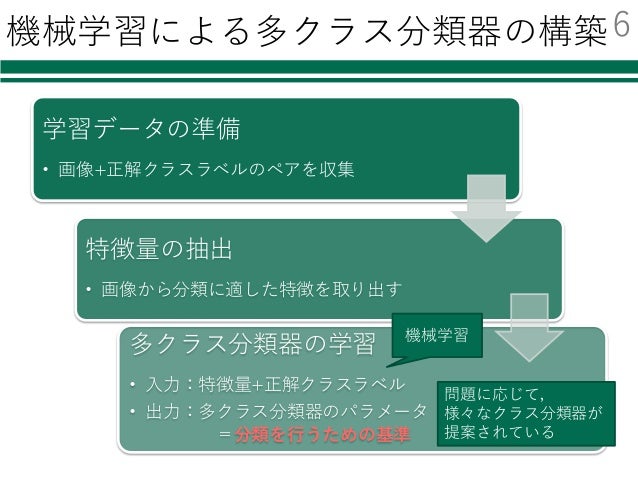

ŷhat Contentbased image classification in Python yhatでpythonを使って簡単な画像分類をするエントリがあったので紹介します。 画像分類のステップ 画像分類を実現するステップは以下の通りです。 学習画像を集める 画像を特徴量に変換する 識別器を学習, モデルを scikitlearnのSVM(SVC)は,多クラス分類を行うとき,oneversusoneで分類する. しかし,oneversustherestの方が識別性能がいい場合がある(多い,という報告を見かける)ので, sklearnmulticlassのOneVsRestClassifierを使った oneversustherestでの多クラスSVM分類 の仕方をメモしておく. (注)ただし,LinearSVCはデフォルトでoneversustherestを採用し低~中次元のデータセットで精度を向上させカーネル関数を選択するには、分類学習器アプリを使用して、SVM バイナリ学習器が含まれているマルチクラス誤り訂正出力符号 (ECOC) モデルまたはバイナリ SVM モデルに学習をさせます。 柔軟性を向上させるには、コマンドライン インターフェイス

サポートベクターマシン Svm の概要

Ml06 マルチクラス分類の概要

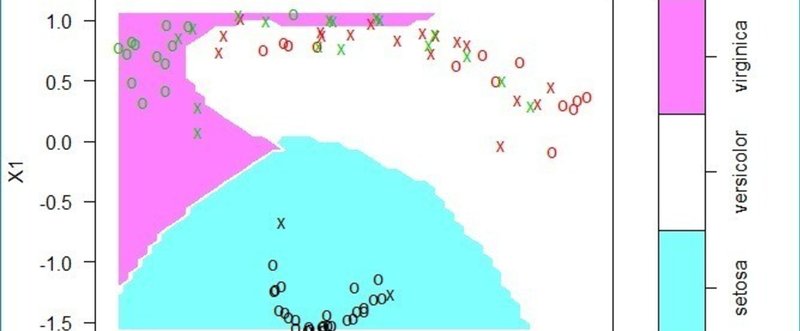

サポートベクターマシン (SVM)とは? 〜基本からPython実装まで〜 こんにちは. 今日は機械学習の一つである サポートベクターマシン について書いていきます. 分類とか回帰などの問題を解くときに使われる手法で,1960年代からある手法です. ここでは ここでは、 scikitlearn の SVM モジュールを使用して 多クラス分類問題 を解いてみる。 SVMを使用した2クラス分類問題は以下。 Pythonで機械学習 SVMで2クラス分類問題編 データセットは、以下で紹介している digits データセット を使用する。 Pythonで機械学習 データセット編 後半で実施している精度 はじめに 先に断っておくと、class_weightの挙動はモデルによって異なる可能性が十分ある。 今回はsklearnsvmSVCとsklearnensembleRandomForestClassifierのドキュメントを参照して、一応基本的に共通する部分を抜き出した。 class_weightを調整する必要が出てきたときは、自分が使うモデルで確認してください。 参考:

Pythonで始める機械学習の学習

Pythonによる機械学習入門 Svmからdeep Learningまで

Python 機械学習 svm マージン最大化と呼ばれる考えに基づき、主に2値分類問題に用いられます。多クラス分類や回帰問題への応用も可能です。 scikitlearn 使い方(機械学習)多クラス分類 scikitlearnライブラリを使った、ロジスティック回帰分析による 多クラス分類の方法 を紹介します。 以前、紹介したロジスティック回帰分析では、2値( or ×)を予測しましたが、3値( or or ×)や4値( or or ×)など、多数のクラスに分類(予測)し 機械学習による分類手法の1つに、SVM(サポートベクトルマシン)があります。 SVMは、 データの点の間に境界線を引くことで分類をおこなうアルゴリズム です。 データの距離が最長になるように境界線を引くという仕組みになっています。 とはいえ、これだけではちょっとピンとこないですよね。 この後、もう少し詳しく説明をします。 そんなSVMは、 実はPython

Scikit Learn手法徹底比較 Svm編 Risky Dune

Sklearnのclassification Reportで多クラス分類の結果を簡単に見る 静かなる名辞

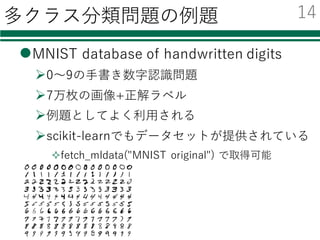

scikitlearnのSVMを使って多クラス分類を試す Python のscikitlearnを勉強中です。 今回は、公式ページにある、 手書き 文字を0から9に分類するコード ( Recognizing handwritten digits — scikitlearn 0161 documentation) を読み解いてみます。 Python Tech プログラミング 機械学習 こんにちは、ぐぐりら ( @guglilac )です。 今回は、2クラス分類器を多クラス分類器へと拡張する手法である、OneVSRest (一対他) とOneVSOne (一対一)を実装して、 ロジスティック回帰に適用する実験を行ってみます。 SVMとは SVM(サポートベクトルマシン/サポートベクターマシン)は機械学習モデルの一種で、非常に強力なアルゴリズムです。 教師あり学習で、分類や回帰に使われます。 Deep Learningが流行る前の世代ではその非常に高い汎化性能と使いやすさから、本当に広い分野で使われていました。 マージン最大化という考え方、カーネル法という非線形への拡張などが肝です

Scikit Learnで混同行列を生成 適合率 再現率 F1値などを算出 Note Nkmk Me

Pythonによるsvm サポートベクターマシン の実行 データサイエンス情報局

SVCやNuSVCは多クラス用の"1対1″(oneagainstone)(Knerr et al, 1990)の手法を使っている。 (他クラスSVM)と呼ばれるもう1つの他クラス分類のための手法もカバーしている。この手法は"multi_class='crammer_singer'"と指定することで使用可能である。 Pythonの関数を

Pythonで始める機械学習の学習

Pythonによる機械学習入門 Svmからdeep Learningまで

Svm 多クラス分類 Qiita

線形モデルによる多クラス分類 Taustation

プログラム コード公開 コピペだけで実用的かつ実践的な多クラス分類用サポートベクターマシン Support Vector Machine Svm R言語 Univprof Note

Scikit Learnを用いた多クラス分類 2 3 他力本願で生き抜く 本気

Linear Svc クラス分類 Svm Classification Pythonとscikit Learnで機械学習 第3回

第8回 分類問題をディープラーニング 基本のdnn で解こう Tensorflow 2 Keras Tf Keras 入門 1 3 ページ It

One Class Svm による外れ値検知についてまとめた コンサルでデータサイエンティスト

年5月 Taustation

Ibm Qiskit 量子サポートベクターマシンによる量子機械学習とmnist多クラス分類の進め方 By Tetsuro Tabata Blueqat

Kernel Svc クラス分類 Svm Classification Pythonとscikit Learnで機械学習 第5回

Pythonで機械学習 Scikit Learnでsvmを実装する パソコン工房 Nexmag

Pythonのsvmで多クラス分類をする Qiita

Pythonで始める機械学習の学習

Python機械学習初心者用 サポートベクターマシンの概要と実装 Watlab Python 信号処理 Ai

Linear Svc クラス分類 Svm Classification Pythonとscikit Learnで機械学習 第3回

クラス分類 の新着タグ記事一覧 Note つくる つながる とどける

Generative Adversarial Network Wikipedia

Pythonによる機械学習入門 Svmからdeep Learningまで

Qsvm 多クラス分類 Qiskit 0 26 1 ドキュメント

Python Sklearnのk近傍法 Knnで多クラス分類する Watlab Python 信号処理 Ai

Python機械学習ライブラリ Scikit Learn活用レシピ80 Impress Top Gear Julian Avila Trent Hauck 株式会社クイープ 本 通販 Amazon

Svmを使いこなす チェックポイント8つ Qiita

プログラム コード公開 コピペだけで実用的かつ実践的な多クラス分類用サポートベクターマシン Support Vector Machine Svm R言語 Univprof Note

パッケージユーザーのための機械学習 教師あり学習同士で分離超平面 決定境界を比較してみる 渋谷駅前で働くデータサイエンティストのブログ

Scikit Learn 入門 6つの機能と分類 回帰の実装方法を徹底解説

Svm Support Vector Machine Negativemindexception

入門 Keras 4 多クラス分類 Iris データを学習する 株式会社インフィニットループ技術ブログ

Scikit Learn でクラス分類結果を評価する Python でデータサイエンス

Scikit Learn サポートベクタマシン Svm で教師あり学習 分類器作成 西住工房

多クラス分類 マスプログ

Scikit Learn サポートベクタマシン Svm で教師あり学習 分類器作成 西住工房

1

機械学習の分類結果を可視化 決定境界 見習いデータサイエンティストの隠れ家

Svm Support Vector Machines による他クラス分類の実装と可視化 筋肉で解決しないために

Pythonによる機械学習入門 Svmからdeep Learningまで

Svm の新着タグ記事一覧 Note つくる つながる とどける

Scikit Learn サポートベクタマシン Svm で教師あり学習 分類器作成 西住工房

Knn K近傍 によるクラス分類 マスプログ

適合率 再現率など機械学習分類モデルの評価指標を理解する 多クラス分類 Valueログ

Linear Svc クラス分類 Svm Classification Pythonとscikit Learnで機械学習 第3回

サポートベクターマシン Svm とは 基本からpython実装まで

Python機械学習初心者用 サポートベクターマシンの概要と実装 Watlab Python 信号処理 Ai

サポートベクターマシン Svm の概要 機械学習

Scikit Learn でクラス分類結果を評価する Python でデータサイエンス

Scikit Learnを用いた多クラス分類 3 3 他力本願で生き抜く 本気

サポートベクトルマシンの考え方 Logics Of Blue

Python 非線形svm 2次元 可視化

サポートベクトルマシンの考え方 Logics Of Blue

Svm の新着タグ記事一覧 Note つくる つながる とどける

サポートベクターマシン Svm とは 基本からpython実装まで

Svmとは Scikit Learnを使ってsvmでクラス分類する方法を解説 Ai研究所

One Class Svm 分類アルゴリズム Svm を利用した外れ値検知

Scikit Learnでサポートベクターマシン Svm を使う方法 エビワークス

Scikit Learnのsvmを使って多クラス分類を試す Minus9d S Diary

動く 機械学習帳 東工大教授が講義資料を無償公開 回帰や分類のグラフをアニメーションに Itmedia News

Svm 多クラス分類 Qiita

9 1 In1 Matplotlib Inline Import Numpy As

Pythonによるsvm サポートベクターマシン の実行 データサイエンス情報局

Scikit Learn でクラス分類結果を評価する Python でデータサイエンス

Pythonで始める機械学習の学習

初心者流 Courcera 機械学習 Week 3を解く 内容 多クラス分類 過学習 なんちゃってitエンジニアゆたろのブログ

サポートベクターマシンまとめ 創造日記

Pythonでできる 分かりやすいsvm サポートベクターマシン 2年でデータサイエンティストになった人が教える 初心者のためのai データ分析

適合率 再現率など機械学習分類モデルの評価指標を理解する 多クラス分類 Valueログ

Svm 多クラス分類 Qiita

3

Linear Svc クラス分類 Svm Classification Pythonとscikit Learnで機械学習 第3回

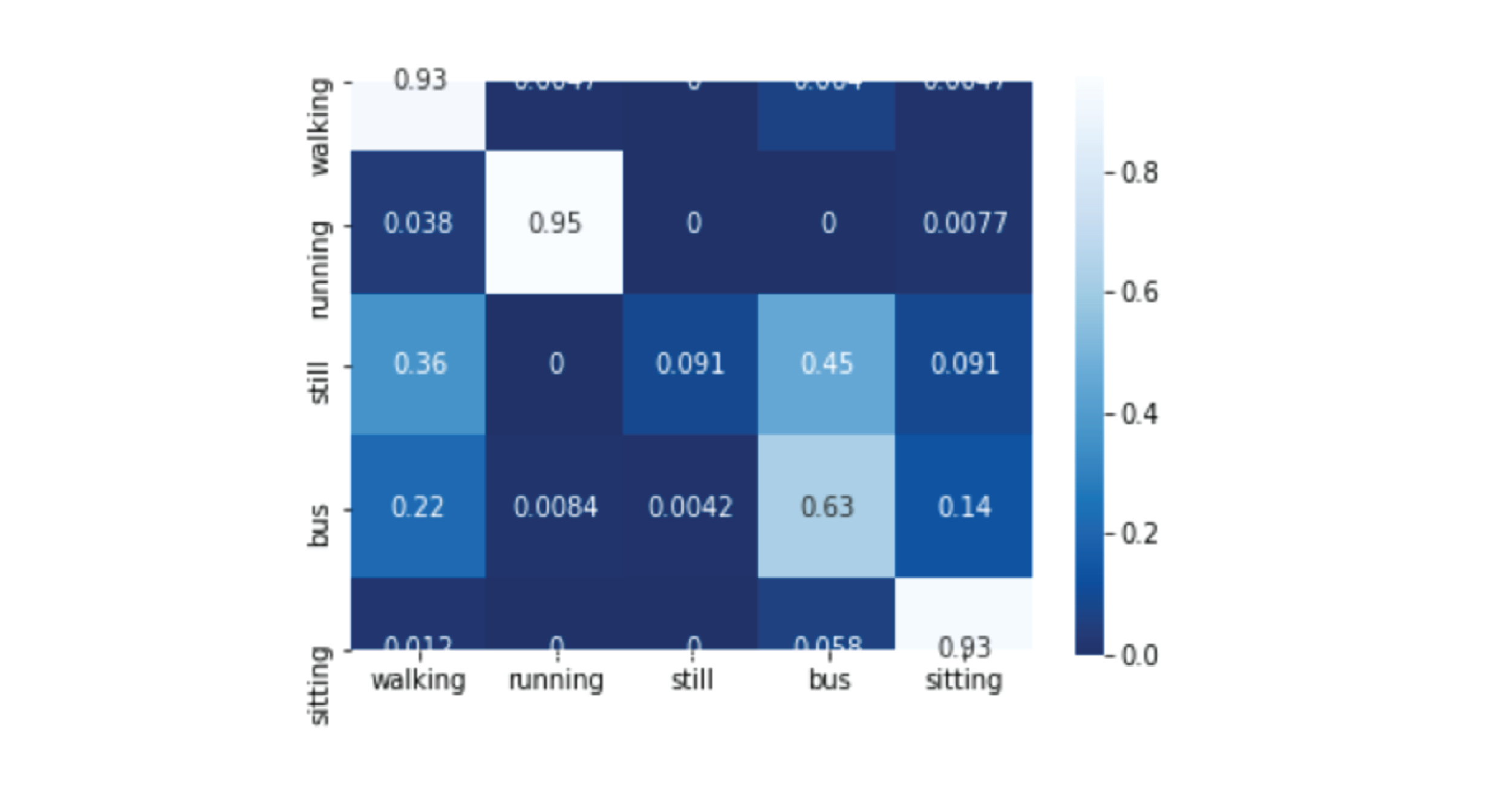

Scikit Learn For Simple Human Activity Recognition Yuuki Nishiyama

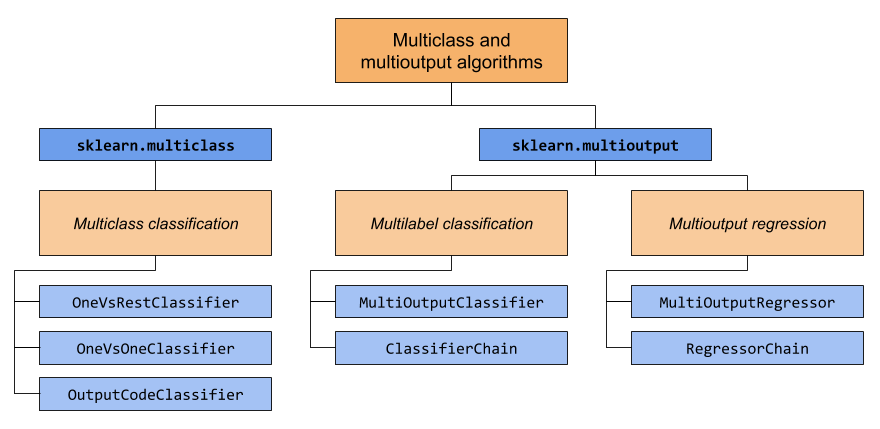

1 12 Multiclass And Multioutput Algorithms Scikit Learn 1 0 2 Documentation

Python入門 4 3 3 Scikit Learnとsvm サポートベクターマシン で多クラス分類 機械学習 Youtube

Statistics Tm23forest Com

Svm の新着タグ記事一覧 Note つくる つながる とどける

機械学習手法 Svm サポートベクトルマシン でクラス分類に挑戦 侍エンジニアブログ

Kernel Svc クラス分類 Svm Classification Pythonとscikit Learnで機械学習 第5回

たくさんの 倫理的 生きる 多クラス分類 その他 Rikejo S Jp

サポートベクターマシン Support Vector Machine Svm 優秀な 非線形 判別関数

9 1 In1 Matplotlib Inline Import Numpy As

Sklearn Svm Oneclasssvm Scikit Learn 1 0 2 Documentation

線形判別分析 Linear Discriminant Analysis Lda 多クラスにも応用できる線形クラス分類

初心者向け Pythonでsvm サポートベクトルマシン を実装する方法 Aizine エーアイジン

Svm 多クラス分類 Qiita

サポートベクターマシン Svm とは 基本からpython実装まで

Pythonによる機械学習入門 Svmからdeep Learningまで

Python機械学習初心者用 サポートベクターマシンの概要と実装 Watlab Python 信号処理 Ai

入門 Keras 4 多クラス分類 Iris データを学習する 株式会社インフィニットループ技術ブログ

Receiver Operating Characteristic Roc Scikit Learn 1 0 2 Documentation

0 件のコメント:

コメントを投稿